近日,网信院陈晓峰教授团队的最新研究成果“GDR-GMA: Machine Unlearning via Direction-Rectified and Magnitude-Adjusted Gradients”与“Balancing Generalization and Robustness in Adversarial Training via Steering through Clean and Adversarial Gradient Directions”被国际顶级会议ACM MM 2024收录。论文的第一作者分别为陈晓峰教授和张肖瑜副教授共同指导的2022级博士生林燊与2022级硕士生童昊宇。

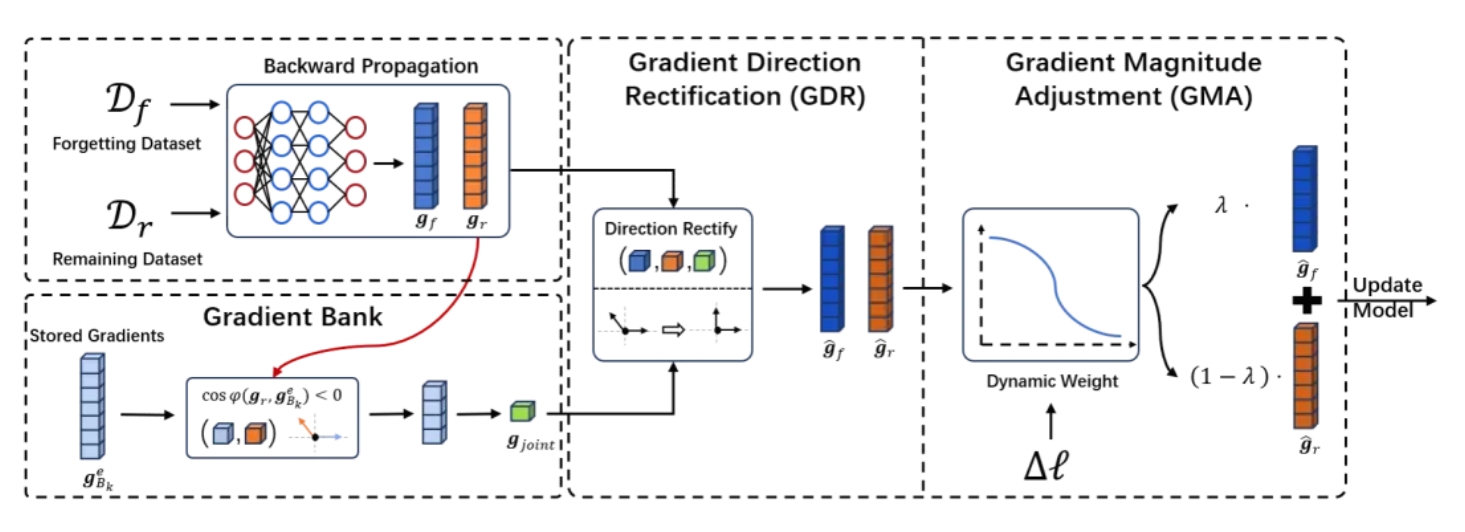

“GDR-GMA: Machine Unlearning via Direction-Rectified and Magnitude-Adjusted Gradients”主要论述数据遗忘技术旨在保护法律赋予用户的被遗忘权,即用户有权利要求模型服务提供商删除用户的数据及其模型学习到的相关知识。然而,数据遗忘技术面临着数据难以彻底删除(有效性)、降低模型分类性能(保真性)、时间开销大(高效性)等问题。本文首次从多任务学习的角度进行分析并发现了造成上述问题的两个关键原因:梯度方向问题——遗忘任务与学习任务的梯度方向相互冲突导致性能下降;梯度主导问题——模型由遗忘梯度或学习梯度主导更新,表现为模型不更新或性能急剧下降。

针对梯度方向问题,本文提出了GDR方法,该方法首先对梯度进行近似计算,在不损失性能的前提下大幅减小计算开销。随后,GDR校正梯度方向使得梯度的更新方向彼此不冲突的同时遗忘目标数据以及保持非目标数据的知识。此外,针对梯度主导问题,本文提出了GMA方法,该方法根据不同的梯度状态对梯度幅度进行动态调整,使得不同的梯度之间在处于平衡的状态下共同更新模型。实验证明了GDR-GMA能够在保持模型性能的前提下有效且高效的使模型遗忘数据,并且GDR-GMA具有优秀的可扩展性,能够适用于不同的数据遗忘任务与网络结构。

“Balancing Generalization and Robustness in Adversarial Training via Steering through Clean and Adversarial Gradient Directions”主要论述在深度学习对抗攻防领域,对抗样本通过微小的输入端扰动即可混淆模型预测,严重威胁其安全性与稳定性,削弱深度学习系统在实际应用中的可靠性。对抗训练旨在利用对抗样本作为训练集以提高深度神经网络的鲁棒性。然而,对抗样本训练集固有的恶意扰动显著干扰了鲁棒模型的泛化性能。

本文通过研究干净样本与对抗样本的损失函数关于模型的梯度分布表现,发现在神经网络不同层参数上的两梯度间存在差异甚至冲突,使得对抗训练梯度更新过程出现对抗样本的损失函数值降低而干净样本损失函数值上升的情况,从而导致最终训练出的鲁棒模型的泛化性能不足,通过该现象本文直观地揭示了对抗训练制约模型泛化性能优异表现的成因。本文还进一步提出了自适应梯度重构对抗训练方法AGR,包括梯度投影模块和梯度插值模块。AGR的核心作用在于能够在模型训练过程中动态调整鲁棒梯度方向和幅值,从而有效化解梯度冲突。此外,从理论上证明了AGR的基于拉德马赫复杂度的泛化误差上界优于目前的SOTA方法。实验证明了AGR在对抗环境中能够显著提高鲁棒模型的泛化性能,具有高可靠、广适用、强兼容等优点。

据悉,国际多媒体会议(The 32th ACM International Conference on Multimedia,简称ACM MM)将于10月28日至11月1日在澳大利亚墨尔本举行,该会议是计算机图形学与多媒体领域顶级会议,被中国计算机学会(CCF)列为A类会议。

人工智能安全是新兴的跨学科领域,这两篇相关工作的录用展示了睿云数据安全团队在该领域取得的重要研究成果,助力学科技术创新全面发展。